robots.txt

robots.txt とは、どのページを巡回してよいか/否かを検索ロボットに知らせるためのものです。

検索ロボットはサイト内の web ページを巡回し、Google Search Console でみられるような検索インデックスを作成します。

robots.txt で巡回を拒否すると結果として検索インデックスの候補にもなりません。

既に robots.txt を作成されている場合でファイルを確認するにはrobots.txt テスターで robots.txt をテストする

から辿ってみてください。

web ページにおける <meta name="robots" content="index,follow" /> と同じような機能があるのですが、robots.txt では巡回を拒否できますので確実に検索インデックスの対象にしないことができます。

Google の robots.txt についてはrobots.txt の概要

を参照してください。

ただし、Google Search Console での解説では基本的にロボットの巡回や検索インデックスの拒否は <meta name="robots" content="noindex,nofollow" /> のように <meta> タグで指定するように勧告されています。

<meta> タグを使用していないようなドキュメントやどうしても巡回を拒否したいページのみを robots.txt の記載したほうがよいようです。

ページ内 Index

robots.txt の効果

robots.txt は、検索ロボットに対して巡回の許可/拒否を確実に知らせます。

Google Search Console でページのインデックス登録

において未登録

や登録済み

を見たことはないでしょうか。

Google Search Console のページのインデックス登録

は、有効なページであるか/否かを表し、有意義なページであるか/否かを意味します。

登録済み

は有効なページなのですが、未登録

ページは価値のないページとみなされ、未登録

ページが多いほど価値の低いサイトと見なされます。

未登録

ページが少ないほうがよいサイトとして検索インデックスのより上位に掲載される傾向があります。そのことが、SEO 対策としてよい効果をもたらすのです。

robots.txt は、Google のサーチロボットに対して巡回の許可/拒否を確実に知らせ、結果として未登録

ページを減らす効果があります。

ただし、重複やリダイレクトに関して未インデックスのURLは robots.txt で拒否していまうと、利用されるべき URL も巡回の拒否対象になります。必ずテストするようにして下さい。

robots.txt の書き方

詳しい robots.txt の作成方法は Google のドキュメントrobots.txt の書き方、設定と送信

にあります。ここでは、簡単に解説します。

robots.txt の内容は以下のようにUser-Agent

、Disallow

、Allow

、Sitemap

で構成されます。

- User-Agent

- サーチロボットの指定。*にしておく

- Disallow

- ページの Index 不可の指定

- Allow

- ページの Index 可の指定

- Sitemap

- サイトマップファイルの場所を指定

ここでは検索にインデックスされたくないページを登録しますのでAllow

は使いません。また、デフォルトでDisallow

で拒否しない限りはすべてのページがAllow

になります。

例えば、/Example/non-index.html

ページをインデックスしないように、サイトマップは直下sitemap.xml

である場合は以下のように編集します。

User-Agent:* Disallow:/Example/non-index.html Sitemap:https://example.jp/sitemap.xml

インデックスして欲しくないページが複数ある場合は以下のように1ページずつ Disallow: で指定します。

User-Agent:* Disallow:/Example/non-index.html Disallow:/Example/no-index.html Disallow:/Example/nonnon-index.html Sitemap:https://example.jp/sitemap.xml

ディレクトリごと指定する場合は、以下のようにします。

... Disallow:/Example/ ...

robots.txt の内容が編集できたら保存しましょう。ファイル名はもちろんrobots.txt

です。

次に、保存したrobots.txt

をサイトのルートディレクトリにアップロードします。Google のサーチロボットはルートディレクトリにある robots.txt を自動で参照します。

robots.txt ファイルはルートディレクトリにあるという前提になっています。

アップロード前のテスト

robots.txt ファイルをアップロードしないでテストすることもできます。

robots.txt テスターで robots.txt をテストする

にあるrobots.txt テスターを開く

からテスターを開きます。

テスターを開いたら、確認済みのプロパティを選択

でサイトを選択してください。

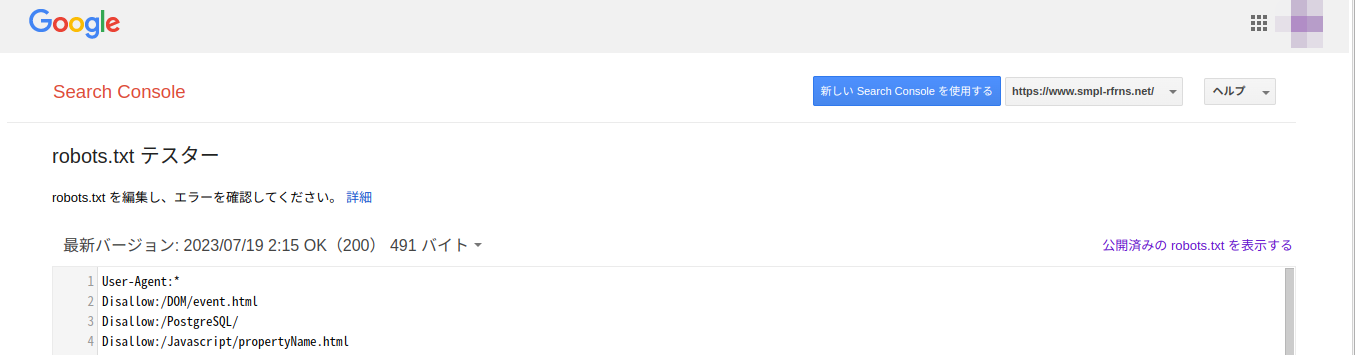

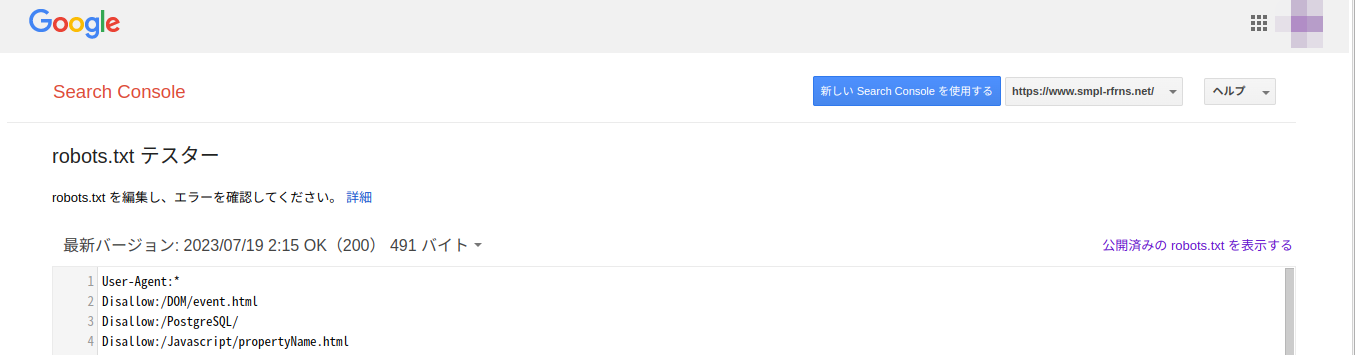

robots.txt テスター

以下の編集エリアで上記のような robots.txt の内容を編集し、下の URL 入力欄にテストしたいページを入力後、テスト

をクリックします。

すると、許可済み/ブロック済みで 検索ロボットの巡回が許可されているか/拒否されているかが分かります。

robots.txt のテスト

アップロードした robots.txt の内容をテストするにはrobots.txt テスターで robots.txt をテストする

にあるrobots.txt テスターを開く

からテスターを開きます。

テスターを開いたら、確認済みのプロパティを選択

でサイトを選択してください。

しばらくすると、アップロードした robots.txt が読み込まれていればその内容が表示されます。

最下部の URL 入力欄にテストしたいページを入力後、テスト

をクリックします。

すると、許可済み/ブロック済みで 検索ロボットの巡回が許可されているか/拒否されているかが分かります。

robots.txt は Google Search Console において優良なサイトであるかを測る要素になります。 SEO 対策として試してみてはいかがでしょうか。